Data Mining bedeutet, mit intelligenten Verfahren verborgene Zusammenhänge in großen Datenmengen sichtbar zu machen. Ob für Unternehmen oder Privatpersonen: durch moderne Datenverarbeitung sowie den Einsatz von maschinellem Lernen und verschiedenen Quellen eröffnen sich heute ganz neue Möglichkeiten, wertvolle Informationen zu gewinnen und gezielt nutzbar zu machen.

Data Mining „kurz erklärt“

Data Mining bedeutet, in großen Datenmengen automatisch Muster und Zusammenhänge zu erkennen. Statt Daten nur zu speichern, werden sie gezielt analysiert. Es ist ein analytischer Prozess, der häufig auf maschinelles Lernen zurückgreift. Ziel ist es, wertvolle Informationen und aufschlussreiche Informationen zu gewinnen, etwa für Empfehlungen, Vorhersagen oder Entscheidungen.

Definition: Data Mining

Data Mining ist ein Teilgebiet der Datenanalyse und bezeichnet den umfassenden Prozess, bei dem große Datenbestände mit statistischen und algorithmischen Methoden systematisch untersucht werden, um bislang unbekannte Strukturen und gefundene Muster sichtbar zu machen.

Im Unterschied zur klassischen Analyse von Daten erfolgt Data Mining automatisiert, oft mithilfe von maschinellem Lernen. Dabei handelt es sich um einen analytischen Prozess, bei dem die Daten selbst neue Erkenntnisse liefern, ohne dass zuvor Hypothesen definiert werden müssen.

Abgrenzung zu verwandten Begriffen:

- Big Data: Große, komplexe Datenmengen, die oft erst durch Data Mining sinnvoll nutzbar werden.

- Datenanalyse: Übergeordneter Begriff, umfasst die Anwendung von Methoden zur Auswertung von Daten.

- Business Intelligence (BI): Nutzt Ergebnisse aus dem Data Mining zur strategischen Entscheidungsfindung.

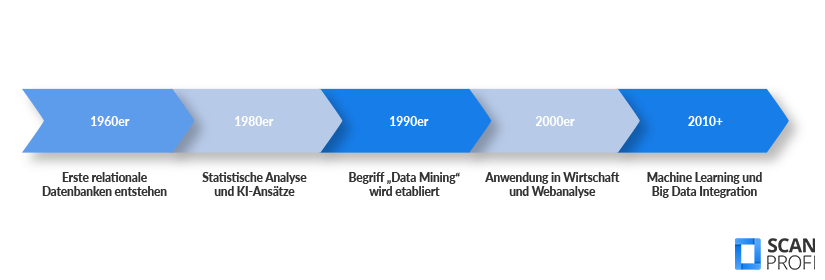

Geschichte

Die Ursprünge des Prozesses reichen zurück bis in die 1960er-Jahre, als erste Datenbanken entwickelt wurden. In den 1980er-Jahren kamen vermehrt statistische Verfahren und erste Algorithmen zur Mustererkennung hinzu, ein früher Vorläufer des heutigen maschinellen Lernens.

Der eigentliche Begriff „Data Mining“ wurde in den 1990ern populär, parallel zur Verbreitung leistungsfähiger Rechner und wachsender Datenmengen. Heute ist es ein zentrales Werkzeug in Bereichen wie Wirtschaft, Forschung, Medizin und Marketing.

Wie funktioniert Data Mining?

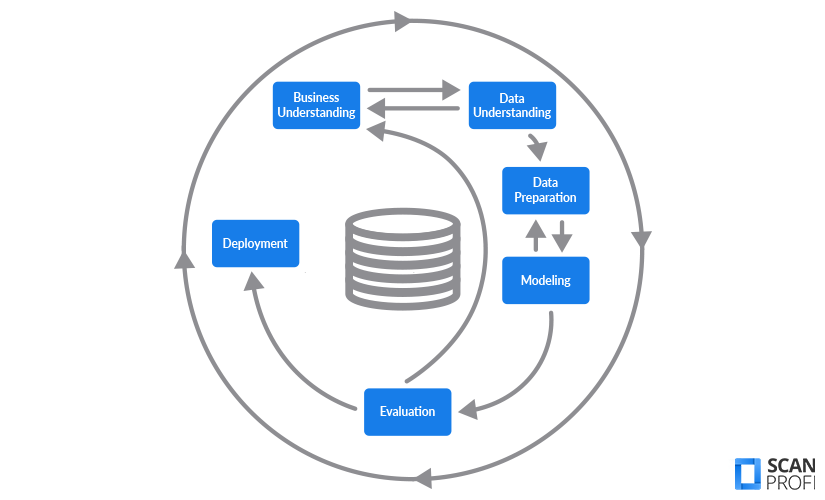

Data Mining folgt in der Praxis meist dem CRISP-DM-Modell (Cross Industry Standard Process for Data Mining), das sich branchenübergreifend als Standard für den gesamten Prozess etabliert hat. Es unterteilt den Prozess in sechs aufeinander abgestimmte Phasen: von der Zieldefinition bis zur Anwendung der Ergebnisse.

Bevor wir tiefer einsteigen, ein Praxistipp: Mit Tools wie Orange Data Mining lässt sich Data Mining auch ohne Programmierkenntnisse direkt ausprobieren. Solche Tools veranschaulichen gut, wie sich mit wenigen Klicks antrainierte Muster aus großen Datensätzen ableiten lassen.

Zu Beginn wird das konkrete Ziel des Projekts geklärt: Was soll mithilfe von Data Mining erreicht werden? Es geht darum, das Geschäftsproblem zu verstehen und in eine analytische Fragestellung zu übersetzen.

Nun werden die verfügbaren Datenquellen analysiert. Es geht darum, relevante Datenbestände auszuwählen, erste Zusammenhänge zu erkennen und mögliche Datenprobleme zu identifizieren (z. B. fehlende Werte, Ausreißer).

In dieser Phase werden die Daten bereinigt, gefiltert, transformiert und für die Modellbildung vorbereitet. Dieser Schritt ist besonders aufwendig und entscheidend für die Qualität der Ergebnisse.

Hier wird das eigentliche Data-Mining-Modell erstellt. Es werden passende Methoden und Algorithmen ausgewählt und auf die aufbereiteten Daten angewendet, z. B. Entscheidungsbäume, Clustering oder neuronale Netze.

Die Ergebnisse werden bewertet: Liefert das Modell nachvollziehbare und nützliche Erkenntnisse? Sind die Ergebnisse relevant für das ursprünglich definierte Ziel? Falls nötig, wird noch einmal zurückgesprungen.

In der letzten Phase werden die Erkenntnisse praktisch genutzt, z. B. durch die Integration in Geschäftsprozesse oder die Visualisierung in Dashboards. Ziel ist es, die gewonnenen Informationen in den Alltag zu übertragen.

Je nach Ziel und Datenlage kann der Schwerpunkt innerhalb des Modells variieren. Wichtig ist: Alle Phasen tragen maßgeblich zum Gelingen eines Projekts bei. Da die Phasen in einem iterativen Kreislauf miteinander verbunden sind, werden sie bei Bedarf mehrfach durchlaufen und angepasst.

Methoden & Techniken

Je nach Zielsetzung kommen im Data Mining unterschiedliche Verfahren zum Einsatz. Viele davon basieren auf maschinellem Lernen. Sie lassen sich grob in sechs Kategorien einteilen, die jeweils spezifische Aufgaben erfüllen: von der Klassifizierung über die Mustererkennung bis zur Reduktion komplexer Datenstrukturen. Dabei lassen sich beispielsweise Muster erkennen, die auf bekannte Muster trainierter Modelle zurückgreifen oder neue Strukturen offenlegen.

Folgende Verfahren werden erklärt:

Klassifikationsverfahren

Ziel: Kategorisierung von Objekten

Klassifikationsverfahren ordnen Daten bestimmten Klassen zu, etwa „Kunde kauft“ oder „Kunde kauft nicht“. Sie werden häufig für Vorhersagen genutzt, bei denen eine bekannte Zielvariable vorhanden ist.

Clustering-Verfahren

Ziel: Gruppierung ohne Vorwissen

Clustering gruppiert Daten in ähnliche Gruppen (Cluster), ohne dass vorher Klassen definiert werden. So lassen sich z. B. Kundensegmente automatisch erkennen.

Assoziationsanalyse

Ziel: Regelmäßigkeiten entdecken

Diese Verfahren identifizieren häufig auftretende Zusammenhänge in Daten, z. B. welche Produkte häufig gemeinsam gekauft werden („Wer Produkt A kauft, kauft oft auch B“).

Regressionsverfahren

Ziel: Vorhersage kontinuierlicher Werte

Regressionsmethoden sagen Zahlenwerte voraus, z. B. den zukünftigen Umsatz oder Temperaturverlauf. Anders als bei der Klassifikation ist das Ergebnis kein Label, sondern ein konkreter Zahlenwert.

Anomalieerkennung

Ziel: Abweichungen identifizieren

Anomalieerkennung hilft, Ausreißer oder verdächtige Muster in Daten zu erkennen, etwa bei der Betrugserkennung im Zahlungsverkehr oder bei Produktionsfehlern.

Dimensionalitätsreduktion

Ziel: Komplexität reduzieren

Bei großen Datenmengen mit vielen Merkmalen hilft die Dimensionalitätsreduktion, die Daten übersichtlicher und effizienter analysierbar zu machen – ohne wichtige Informationen zu verlieren.

Anwendungsgebiete

Data Mining findet in vielen Bereichen des täglichen Lebens und der Wirtschaft Anwendung. Ob personalisierte Werbung, Betrugserkennung oder wissenschaftliche Studien. Überall dort, wo große Datenmengen anfallen, lassen sich durch gezielte Analyse wertvolle Erkenntnisse gewinnen.

Unternehmen analysieren das Kaufverhalten ihrer Kundschaft, um gezielte Werbemaßnahmen zu entwickeln, etwa für individuelle Rabattaktionen oder Produktempfehlungen.

Banken und Versicherungen nutzen Data Mining zur Erkennung verdächtiger Transaktionen. Anhand von Mustern und Abweichungen vom üblichen Verhalten lassen sich Betrugsversuche frühzeitig erkennen.

Produktionsdaten werden analysiert, um Qualitätsprobleme aufzudecken oder vorherzusagen. So können Fertigungsfehler reduziert, Wartungszyklen optimiert und Prozesse effizienter gestaltet werden.

Streamingdienste, Online-Shops und soziale Netzwerke nutzen Data-Mining, um personalisierte Inhalte vorzuschlagen. Die Systeme lernen aus dem Userverhalten und verbessern ihre Empfehlungen stetig.

In der medizinischen Forschung, Klimaforschung oder Sozialwissenschaft werden mithilfe von Data Mining neue Zusammenhänge entdeckt.

Vorteile und Herausforderungen

Data Mining bringt viele Chancen mit sich, aber auch einige Risiken, die man kennen sollte.

Vorteile

✅ Entwicklungen von Trends werden schneller sichtbar

✅ Vorhandene Daten können neue Erkenntnisse liefern

✅ Geschäftsprozesse lassen sich datenbasiert optimieren

✅ Nutzende erhalten maßgeschneiderte Angebote und Empfehlungen

✅ Automatisierte Entscheidungen bei Betrugsprüfung oder Wartungsplanung

Herausforderungen

❌ Große Datenmengen sind oft notwendig

❌ Der Prozess zeigt Muster, aber keine Ursachen

❌ Ohne Fachkenntnisse kann die Analyse scheitern

❌ Personenbezogene Daten dürfen nur rechtssicher genutzt werden

❌ Schlechte oder einseitige Daten können zu unfairen Ergebnissen führen

Statistik vs. Data Mining

Obwohl Statistik und Data Mining ähnliche Werkzeuge nutzen, unterscheiden sie sich in Zielsetzung und Anwendung. Hier ein kompakter Überblick:

Kriterium

Statistik

Data Mining

Datenmenge

Eher kleine, strukturierte Stichproben

Große, oft unstrukturierte Datenmengen

Zielstellung

Hypothesen prüfen

Muster und Zusammenhänge entdecken

Berechnung

Theoriebasiert, oft manuell/modellgeführt

Automatisiert, mit Algorithmen und KI

Voraussetzungen

Fachliche Annahmen vorab notwendig

Hypothesenfrei und explorativ

Übertragbarkeit

Ergebnisse meist spezifisch

Oft auf neue Daten anwendbar

Statistik erklärt, was man bereits vermutet. Data Mining entdeckt, was man bisher nicht wusste.

Data Mining & Digitalisierung

Data Mining entfaltet sein Potenzial erst, wenn Daten digital und strukturiert vorliegen. Genau hier setzt die Digitalisierung an: Werden analoge Informationen, etwa Papierdokumente, Ordner oder Fotoalben, professionell eingescannt, entsteht die nötige Datenbasis für Analysen.

ScanProfi unterstützt Unternehmen und Privatpersonen dabei, ihre analogen Datenbestände in durchsuchbare, maschinenlesbare Formate umzuwandeln. Das schafft die ideale Grundlage für moderne Datenanalysen und automatisierte Auswertungen.

Häufig gestellte Fragen

Data Mining ist die automatisierte Suche nach Mustern, Zusammenhängen und Trends in großen Datenmengen.

Teilweise. Viele Data-Mining-Methoden nutzen Algorithmen, die auch in der KI eingesetzt werden, aber nicht jedes Data Mining ist automatisch KI.

Das Ziel ist, aus vorhandenen Daten neue, nützliche Erkenntnisse zu gewinnen, um Entscheidungen, Prognosen oder Optimierungen zu unterstützen.

Mögliche Nachteile sind Datenschutzrisiken, fehlerhafte Interpretationen und die Abhängigkeit von großen, qualitativ hochwertigen Datenmengen.

Ja, solange der Datenschutz eingehalten wird und die Analyse rechtlich zulässige Daten nutzt, ist es legal.